Supercomputer – VSC

Der Vienna Scientific Cluster (VSC) ist ein Supercomputer für ausgewählte wissenschaftliche Projekte mit einem Bedarf an extrem hoher Rechenleistung. Die aktuelle Ausbaustufe ist der VSC-5.

Der VSC wird in einer Kooperation zwischen der Technischen Universität Wien, der Universität Wien, der Universität für Bodenkultur Wien, der Technischen Universität Graz und der Universität Innsbruck betrieben.

VSC nutzen

Der Zugang zum Vienna Scientific Cluster erfolgt grundsätzlich auf Basis von Projekten, die

- einen Peer-Review-Prozess erfolgreich durchlaufen haben und

- neben wissenschaftlicher Exzellenz

- den Bedarf an extrem hoher Rechenleistung nachweisen.

Sofern es sich um Projekte handelt, die bereits vom FWF, der EU usw. positiv begutachtet wurden, ist kein weiterer Review-Prozess erforderlich. Zum Einreichen von Projekten und Beantragen von Ressourcen steht das VSC-Formular der TU Wien zur Verfügung.

Zusätzlich werden rasch und unbürokratisch Testaccounts vergeben (befristet und mit begrenzten Ressourcen).

Mehr Informationen über die Nutzung des VSC finden Sie im VSC Wiki.

Nutzer*innen der Universität Wien

- Es stehen Zugangsknoten zur Verfügung, die über

vsc4.vsc.ac.atundvsc5.vsc.ac.atzu erreichen sind. Diese befinden sich logisch im Datennetz der Universität Wien. - Physikalisch wurde die Verbindung zwischen Universität Wien und TU Wien auf 10 Gbit/s aufgestockt, sodass auch der Transfer großer Datenmengen zwischen dem VSC und Servern an Instituten der Universität Wien problemlos möglich ist.

Fragen zum VSC an service@vsc.ac.at.

VSC-5

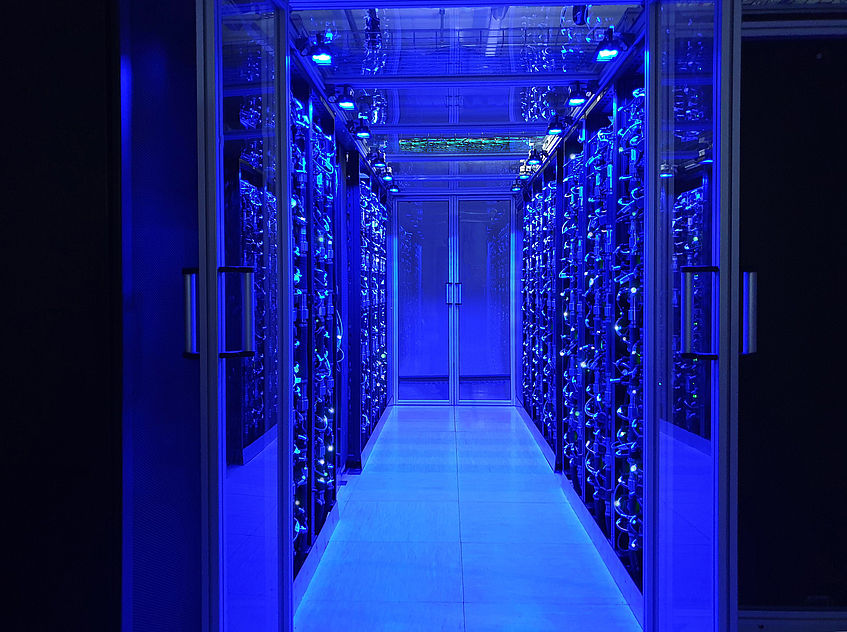

VSC-5 (Vienna Scientific Cluster) © VSC-Team

VSC-5

Die fünfte Ausbaustufe des Vienna Scientific Cluster – VSC-5 – befindet sich im Wiener Arsenal und ist seit 2022 in Betrieb. Der VSC-5 belegt

- Platz 301 in der TOP500-Liste der weltweit schnellsten Supercomputer (Stand Juni 2022).

Hard- und Software

- Insgesamt enthält das System 98.560 Kerne und 120 GPUs.

- 770 Rechenknoten mit je 2 AMD EPYC 7713 Prozessoren mit je 64 Kernen.

- Jeder Knoten hat in der Grundausstattung 512 GB Hauptspeicher und eine 1,92 TB SSD.

- Von diesen Knoten sind:

- 6 Reserveknoten

- 120 Knoten mit erweitertem Hauptspeicher 1 TB/Knoten

- 20 Knoten mit erweitertem Hauptspeicher 2 TB/Knoten

- 60 GPU Knoten mit je 2 Stück NVIDIA A100 GPU

- 10 Loginknoten mit je 1 EPYC 7713 CPU mit 128 GB.

- 3 Serviceknoten (ähnlich ausgestattet wie Loginknoten).

- Alle Knoten (Rechen-, Login- und Serviceknoten) haben je eine 1,92 TB SSD-Device über PCI-E 3,0 × 4.

- Die Serviceknoten haben je 4 Stück und bilden ein privates CEPH-Storage.

- Das interne Netzwerk ist 200 Gbit Infiniband mit 4:1 Überbuchung.

- Die Loginknoten haben zusätzlich je 25 Gbit Ethernet nach außen.

- Die Verbindung zum Storage erfolgt über 6 × 200 Gbit Infiniband.

- Das Storage wird mit dem VSC-4 geteilt, der mit 12 × 100 Gbit Omnipath angeschlossen ist.

- Das System ist großteils wassergekühlt.

VSC-4

VSC-4

Die vierte Ausbaustufe des Vienna Scientific Cluster – VSC-4 – befindet sich im Wiener Arsenal und ist seit 2019 in Betrieb. Der VSC-4 belegte

- Platz 82 in der TOP500-Liste der weltweit schnellsten Supercomputer.

Hard- und Software

- Basierend auf Lenovo-DWC-System

- Direkt-Wasserkühlung mit bis zu 50 Grad Celsius im Vorlauf

- 90 % der Abwärme in Wasserkühlung

- insgesamt 790 Knoten bestehend aus

- 700 Knoten mit je

- 2 × Intel Platinum 8174 (24 cores, 3,1 GHz)

- 96 GB Hauptspeicher

- Omnipath Fabric

- Omnipath (100 Gbit) Adapter

- 78 fat nodes mit je

- 2 × Intel Platinum 8174 (24 cores, 3,1 GHz)

- 384 GB Hauptspeicher

- Omnipath Fabric

- Omnipath (100 Gbit) Adapter

- 12 very fat nodes mit je

- 2 × Intel Platinum 8174 (24 cores, 3,1 GHz)

- 768 GB Hauptspeicher

- Omnipath Fabric

- Omnipath (100 Gbit) Adapter

- 700 Knoten mit je

Pro Rechenknoten

- 2 × Intel Xeon 8174 24 Core 3.1 GHz CPU 240 W

- 12 × 8/32/64 GB TruDDR4 RDIMMS 2666MHz

- 1 × Intel OPA1O0 HFA

- 1 × Intel 480 GB SSD S4510 SATA

- 1 × 1GbE Intel X722

Login-Knoten

- Lenovo ThinkSystem SR630 Server (1 HE)

- 10 Knoten des Typs Lenovo SR630 lHE (luftgekühlt)

- 2 × Intel Xeon 4108 8 Core 1.8 GHz CPU 85 W

- 12 × 16 GB TruDDR4 RDIMMS 2666 MHz

- 1 × Intel OPA1O0 HFA

- 2 × 10 GbE

- 1 × Intel 480 GB SSD 54510 SATA

- 2 × 550W Platinum Hot-Swap Netzteile

Serviceknoten

- 2 Knoten des Typs Lenovo SR630 lHE (luftgekühlt)

- 2 × Intel Xeon 4108 8 Core 1.8 GHz CPU 85W

- 12 × 16 GB TruDDR4 RDIMMS 2400MHz

- 1 × Intel OPA1O0 HFA

- 4 × 10 GbE

- 1 × RAID 530 8i Adapter

- 6 × 600 GB SAS 10k HDD

- 2 × 550W Platinum Hot-Swap Netzteile

Omnipath (Infiniband) Setup

- 27 Edge Intel OPA 100 Series 48 port TOR Switch dual power supply

- 16 Core Intel OPA 100 Series 48 port TOR Switch dual power supply

Ethernet Setup

- 27 Edge Intel OPA 100 Series 48 port TOR Switch dual power supply

- 16 Core Intel OPA 100 Series 48 port TOR Switch dual power supply

VSC-3 (außer Betrieb)

VSC-3 (außer Betrieb)

Die dritte Ausbaustufe des Vienna Scientific Cluster – VSC-3 – befand sich im Wiener Arsenal und war von 2014 bis 2022 in Betrieb. Der VSC-3 belegte

- Platz 85 in der TOP500-Liste der weltweit schnellsten Supercomputer und

- Platz 86 in der Green500-Liste der weltweit energieeffizientesten Supercomputer (Stand November 2014).

Bei der Wahl des VSC-3 wurde großer Wert auf Green IT gelegt. Das spiegelte sich in energiesparenden Prozessoren und einem effizienten Kühlsystem wider. Dieses verwendete synthetisches Öl, das die Wärme abtransportiert.

Hard- und Software

Der VSC-3 verfügte über insgesamt 2.020 Rechenknoten, die aus folgenden Komponenten bestanden:

- Insgesamt 2.020 Dual-Socket-Rechenknoten mit 32.768 Rechenkernen mit zusammen 130 TB Arbeitsspeicher und InfiniBand-Vernetzung bestehend je aus

- 2 × Intel Xeon E5-2650v2 CPUs (2,6 GHz, 8-Kerne, Codename Ivy-Bridge)

- 64 GB–256 GB Hauptspeicher (DDR3, ECC, 1.866 MHz)

- 2 × Intel QLE7340 Single-Port QDR-InfiniBand HCA (QDR80) Netzwerk

- 5 Zugangsknoten wie Rechenknoten und zusätzlich:

- 2 × 10 GbE Ethernet Ports

- 2 × GbE Ethernet Ports

- redundante Netzteile

- 2 × Bootserver als HA-Cluster wie Rechenknoten jedoch 128 GB RAM

- 8 × 480 GB Enterprise SSD im RAID

- performante IPoIB Implementierung (ConnectX3 Adapter)

- 2 × Masterknoten zum Clustermanagement und Monitoring

- Queuing-System und Cluster Management ist der Workload Manager SLURM

- Paralleles Filesystem, BeeGFS Filesystem basierend

- 500 TB Nettokapazität

- 9 Storage-Server und 8 Storage-Erweiterungseinheiten

- mindestens 20 GB/s Bandbreite

- NFS-Server, Anbindung über QDR-InfiniBand-Netzwerk

- zusammen 1 PB Nettokapazität

- 10 identische NFS-Server

- performante IPoIB Implementierung (ConnectX3 Adapter)

- QDR-InfiniBand-Netzwerk, realisiert als QDR-80

- Insel-Implementierung mit maximal 288 Nodes pro Insel

- Blocking-Faktor innerhalb einer Insel 1:2

- Kühlsystem: Liquid Submersion Cooling

- 23 Kühlcontainer für die Aufnahme der Rechenknoten und InfiniBand-Leaf- und Spine-Switches

- 6 redundante Pumpenmodule inkl. Wärmetauscher

Das System hatte eine Höchstperformance von 584 TFlops.

VSC-3 Plus

Der VSC-3 wurde mit weiteren 864 Dual-Socket-Rechenknoten mit 17.280 Rechenkernen und zusammen 55 TB Arbeitsspeicher zum VSC-3 Plus ausgebaut:

- 816 Knoten mit 64 GB RAM

- 48 Knoten mit 256 GB RAM

- 2 × Intel Xeon CPU E5-2660 v2 (2.20 GHz, 10 Kerne)

- IB Mellanox 56 Gbit/s (4X FDR)

VSC-2 (außer Betrieb)

VSC-2 (außer Betrieb)

Die zweite Ausbaustufe des Vienna Scientific Cluster, der VSC-2, befand sich im Wiener Arsenal. Bei seiner Einführung schaffte er es auf Platz 56 der TOP500-Liste der weltweit schnellsten Supercomputer. Er war von 2011 bis 2018 in Betrieb.

Hard- und Software

- Die 1314 Rechenknoten hatten je zwei AMD Opteron Prozessoren (Magny Cours 6132HE) mit 2,2 GHz Taktfrequenz und 8 Kernen. Jeder Rechenknoten verfügte über 32 GB Arbeitsspeicher und eine 16 GB SSD Festplatte.

- 12 Storageserver und 2 NFS-Server wurden mit 2 Intel Xeon Westmere E5620 (Quadcore) Prozessoren und 48 GB Arbeitsspeicher betrieben. Als Speicherplatz standen 24 TB SAS für Nutzdaten (FHGFS) und 48 TB NFS zur Verfügung.

- Das High Performance InfiniBand Netzwerk umfasste 80 Switches Voltaire Grid Director 4036.

- Als Betriebssystem für den VSC-2 diente Scientific Linux 6.0 mit Intel MPI und Open MPI, als Batchsystem die Oracle Grid Engine und ClustWare-Appliance. Verfügbare Compiler waren unter anderem Intel Fortran und C Compilers sowie GNU Fortran Compiler.

VSC-1 (außer Betrieb)

VSC-1 (außer Betrieb)

Der VSC-1 wurde 2009 an der TU Wien installiert. Bei seiner Inbetriebnahme erreichte der VSC-1 den 156. Platz der TOP500-Liste der weltweit schnellsten Supercomputer (Stand November 2009). Er wurde 2015 außer Betrieb genommen.

Hard- und Software

- Die 436 Rechenknoten (Compute Nodes) hatten je zwei Quadcore-Prozessoren (Intel X5550 Nehalem) mit einer Taktfrequenz von 2,66 GHz (insgesamt: 3488 CPU-Cores). Jeder Rechenknoten hatte 24 GB Hauptspeicher (1,333 GHz DDR3) (insgesamt: 11,2 TB) und eine Festplatte (S-ATA) mit 500 GB.

- Leistung: (R_max) 35,5 TFlops

- Alle Knoten waren mit InfiniBand vernetzt. In der Konfiguration des VSC betrug die Bandbreite 40 Gbit/s, die Latenzzeit für eine Verbindung zwischen beliebigen Knoten lag bei ca. 1,5 Mikrosekunden. Alle InfiniBand-Komponenten stammten von QLogic.

- Als Betriebssystem wurde CentOS eingesetzt, eine für den Server- und High-Performance-Computing-Betrieb optimierte Linux-Variante.

- Als Batchsystem kam die Sun Grid Engine zum Einsatz, parallelisiert wurde mit MPI. Compiler (Fortran, C/C++) und numerische Bibliotheken stammten von Intel.

VSC Research Center

Das VSC Research Center wurde im Rahmen eines Hochschulraum-Strukturmittel-Projektes gestartet. Es bietet ein Ausbildungsprogramm, das auf die Nutzung von Supercomputern zugeschnitten ist, und unterstützt zum Beispiel Nutzer*innen beim Optimieren von Programmen. Die Kurse des VSC Research Centers können von Angehörigen der Partneruniversitäten sowie – bei verfügbaren freien Plätzen – auch von Externen besucht werden.

Im Zuge desselben Projektes wurden auch Dissertant*innen und Postdocs gefördert, um wissenschaftlich hochrelevante Programme zu optimieren, zu dokumentieren und als Open-Source-Software zur Verfügung zu stellen.